Une étude en éducation permanente

réalisée par Les Grignoux et consacrée au thème

La Croyance aux médias

par Michel Condé

Liège, Les Grignoux, 2018

L'étude en éducation permanente proposée ici aborde la question de la croyance aux informations de toutes sortes qui nous sont transmises par les médias. L'esprit « critique » individuel ne suffit sans doute pas à faire le partage entre le vrai et le faux, et il faut prendre en considération la dimension sociale d'une vérité qui n'est jamais donnée en tant que telle mais qui résulte toujours d'une construction et qui implique toujours de multiples médiations. On s'attachera ici à mieux comprendre qui sont les « producteurs » de vérité dans les sociétés développées et quel crédit, quelle confiance - qui n'est jamais absolue - nous pouvons leur accorder.

Cliquez ici pour obtenir une version pdf facilement imprimable de ce document![]()

On connaît le succès tout au long des années 1990 et 2000 de la série télévisée X-Files : Aux frontières du réel qui met en scène deux agents du FBI enquêtant sur des phénomènes « paranormaux ». Si la dimension fictionnelle est certainement reconnue par la grande majorité des spectateurs qui savent bien, par exemple, que les agents Mulder et Scully sont interprétés par des acteurs (David Duchovny et Gillian Anderson), il y a de grandes différences dans la perception des limites de cette fiction. Au moins deux thématiques d'X-Files se sont en effet appuyées sur des croyances partagées par une partie du public, croyances que la série a sans doute contribué en retour à renforcer : il s'agit de celle aux extra-terrestres (ou plus exactement à la présence au moins occasionnelle d'extra-terrestres sur terre ou aux proches abords) et celle relative à l'existence de complots divers, essentiellement gouvernementaux, destinés à masquer cette vérité ou la vérité en général [1]. Ces deux croyances sont fortement articulées l'une à l'autre puisque la naïveté apparente de la première [2] est contrebalancée par la dimension supposée critique de la seconde : les naïfs ne seraient pas ceux qui croient en la présence d'extraterrestres mais ceux qui ne se rendent pas compte qu'ils sont les victimes inconscientes de complots mensongers. Et cette balance se retrouve dans les figures contrastées des deux personnages principaux puisque l'un se fiant d'abord à ses intuitions croit manifestement aux phénomènes paranormaux tandis que l'autre volontiers « rationnelle » (même si elle est également croyante) s'attache à des démarches plus scientifiques bien qu'elle soit régulièrement confrontée à l'inexplicable.

Le public s'est donc certainement partagé entre ceux pour qui la série relève pour l'essentiel de la fiction [3] et ceux qui y ont trouvé une confirmation indirecte de leurs croyances, même si celles-ci restaient vagues et imprécises : personne n'a sans doute cru à l'exactitude factuelle des différents épisodes d'X-Files mais certains y ont certainement vu une illustration de l'existence possible, probable ou certaine d'extraterrestres et surtout des complots destinés à cacher cette « vérité » [4]. Le succès de la série tient donc pour une part à son ambivalence en termes de valeur de vérité, pouvant susciter une adhésion plus ou moins large du public sensible ou non au « paranormal » et aux thèses « complotistes ». Et l'on voit surtout que le crédit accordé à la fiction — même s'il n'est pas entier — dépend largement des croyances différentes des spectateurs.

On soulignera enfin la structure particulière du scénario des différents épisodes de X-Files qui, contrairement aux séries policières classiques, ne donnent à leur fin qu'une toute petite partie des solutions aux intrigues mises en scène, et laissent de nombreux événements (meurtres, disparition de dossiers ou de preuves, apparition inopinée de certains personnages…) non résolus et inexpliqués. Autrement dit, la croyance éventuelle de certains spectateurs en l'existence du « paranormal » ou de complots omniprésents sera renforcée non pas par des faits précis (qui sont toujours susceptibles de relever de la fiction) mais par l'impression générale de mystère et de secret qui imprègne toute la série. Ainsi, la conviction individuelle se construit plutôt à travers un sentiment diffus qui procède par allusion et évocation que par une « démonstration » objective. Que certains faits précis soient infirmés ou simplement signalés comme pure fiction ne mettra dès lors pas fin à ce sentiment vague et général.

Il s'agit là d'un phénomène psychologique bien connu, même si la série X-files permet de comprendre comment la fiction peut renforcer certaines croyances générales déjà installées : nos croyances les plus fortes, les plus profondes ou les plus intimes sont largement insensibles aux « démonstrations » ponctuelles et procèdent plutôt par accumulation de « faits », de « représentations » ou d'« impressions » plus ou moins confuses (aujourd'hui de nature le plus souvent médiatique) qui agissent essentiellement comme confirmation de ces croyances. Cela vaut d'ailleurs aussi pour ceux d'entre nous dont les certitudes sont apparemment les plus « rationnelles » : je peux croire en la science, en ses progrès, en ses théories, en ses découvertes sans avoir jamais mené moi-même un véritable travail « scientifique » et sans être réellement troublé par des querelles, des erreurs et même des falsifications qui apparaissent dans différents champs scientifiques.

On retiendra pour l'instant que les croyances préétablies des spectateurs déterminent largement leur adhésion contrastée aux différentes représentations médiatiques. En outre, la fiction, loin d'être perçue comme fausseté ou invention, peut renforcer, même si c'est de façon vague et confuse, ces croyances et en particulier la croyance en la véracité — au moins partielle — de la fiction. On ajoutera à ce propos qu'un tel crédit accordé à la fiction n'est pas propre aux spectateurs de la série X-Files : le public habituel des films à prétention réaliste (par exemple Raining Stones ou I Daniel Blake de Ken Loach) ou de nombreux films historiques (La Liste de Schindler ou Pentagon Papers de Steven Spielberg et bien d'autres) estime ainsi que les événements mis en scène sont, au moins pour une part authentiques ou qu'ils reflètent une réalité existante.

Peut-on dès lors dépasser ce stade de la croyance et promouvoir un abord critique, rationnel ou objectif des médias ? C'est ce qu'ont cru sans doute ces professeurs de l'Université de Gand (en Belgique) qui ont voulu tester l'esprit critique de leurs étudiants en leur énonçant des affirmations « fausses » comme « tout n'est pas correct dans la théorie de l'évolution de Darwin », « Les jeunes sont les esclaves de Steve Jobs », « Les étudiants n'ont pas d'idées innovantes » [5]. Bien évidemment, les expérimentateurs ont constaté que, loin de faire montre « d'esprit critique », les étudiants ont seulement manifesté leur soumission à l'autorité (comme dans la célèbre expérience de Milgram [6]), et les « maîtres » ont dès lors eu beau jeu de rappeler que l'important « n'est pas seulement d'assimiler des informations mais d'oser penser par soi-même » !

On peut cependant interpréter d'une tout autre manière cette (petite) expérience où ces professeurs donnent sans doute trop facilement le vilain rôle aux étudiants, tout en leur faisant une morale à bon marché : il faudrait « oser penser par soi-même ! ». Il est en effet important de rappeler — avec toute la sociologie de la connaissance [7] — que le savoir est avant tout une construction collective et que tout progrès (ou même la simple maîtrise) en ce domaine repose sur un héritage culturel dont les règles et régularités diverses nous permettent précisément de penser correctement. Ce n'est donc qu'au dernier degré de maîtrise de ces règles et régularités que l'on peut prétendre « penser par soi-même ». Or l'Université est sans doute le lieu par excellence où l'on acquiert ces règles, et c'est une institution qui précisément repose sur un contrat de confiance sans doute implicite mais pleinement prégnant entre professeurs et étudiants : la croyance en l'autorité légitime des maîtres (du moins dans le champ des savoirs) est au fondement même de cette institution. Ainsi, lorsqu'un professeur de littérature déclare du haut de sa chaire que Victor Hugo est né en 1802 et mort en 1885, personne ne lui demandera d'où il tire ses certitudes ; et aucun étudiant en astronomie ne vérifiera ni ne mesurera expérimentalement le mouvement rétrograde de Mars dont l'observation fut pourtant un élément essentiel de la révolution copernicienne puis de la théorie de Kepler sur l'orbite elliptique des planètes ! Si les étudiants devaient procéder de manière hyper-critique en vérifiant par eux-mêmes toutes les affirmations de leurs professeurs, ils passeraient leur cursus entier à vérifier des vérités qui ont été démontrées ou établies depuis des siècles ! « Penser par soi-même », « exercer son esprit critique » sont en réalité des lieux communs de notre société extrêmement individualiste qui méconnaît le poids mais également la richesse de notre héritage culturel (au sens le plus large) : c'est cet héritage plus ou moins maîtrisé qui nous permet de penser — de façon exceptionnelle — de manière réellement « libre » et innovante.

Si l'on excepte les mathématiques ou la logique, qui constituent des savoirs extrêmement formalisés reposant sur des procédures aussi explicites que possible [8], toutes les sciences naturelles ou humaines reposent sur des connaissances, des démonstrations, des interprétations, des observations qui ne sont plus questionnées ni mises en doute, du moins lors de la transmission scolaire ou universitaire : les éventuelles vérifications dans une telle situation sont extrêmement limitées — oui, l'eau bout à 100° sous 1 atmosphère, et la dissection de la grenouille révèle les mêmes organes internes que chez la souris : poumons, estomac, intestins, reins, foie… —, et la croyance — croyance qui n'est évidemment pas absolue — fait partie de manière tout à fait légitime des connaissances scientifiques (au sens le plus large) et de leur transmission. D'une certaine manière, l'expérience de ces professeurs gantois sape une base essentielle de la relation pédagogique, à savoir la confiance spontanée en l'autorité scientifique de ceux et de celles qui font partie de l'institution universitaire et dont le crédit dépend notamment de la reconnaissance de leurs pairs (n'eût-elle été accordée que sous forme de diplômes). Elle risque ainsi de participer à une forme d'hyper-critique (que ses promoteurs entendaient pourtant dénoncer) qui rejette toute autorité savante présentée comme dogmatique, arbitraire et non-vérifiée, sinon même intéressée.

On peut même avancer que la valorisation de l'esprit critique (qui est, on l'a dit, un des lieux communs de nos sociétés individualistes) est un leurre si l'on considère non plus le champ limité des savoirs universitaires mais celui beaucoup plus vaste des médias (où ont d'ailleurs pris place une grande partie des savoirs universitaires). Personne n'a la capacité de vérifier de façon individuelle l'ensemble des affirmations, énoncés et représentations de toutes sortes qui emplissent aujourd'hui de façon démesurée ces médias. Si je lis le moindre article de journal sur le conflit israélo-palestinien, je ne vais évidemment pas vérifier — par quels moyens d'ailleurs ? — que l'État d'Israël existe vraiment, que la Palestine est bien une région du Moyen Orient, qu'un conflit violent ou larvé existe entre ces deux entités depuis au moins 1948, qu'Israël domine militairement la région avec notamment le soutien des États-Unis, que les Palestiniens ont recouru à une résistance armée souvent qualifiée de terroriste pour affirmer leurs droits, etc. La lecture du moindre article de journal suppose ainsi une masse de connaissances qui ne font l'objet d'aucun examen critique individuel et qui sont fondamentalement des faits de croyance. Cela ne signifie évidemment pas que les lecteurs de journaux que nous sommes tous sont des naïfs manquant complètement d'esprit critique : nous devons faire confiance à ceux qui nous transmettent collectivement et depuis des siècles un ensemble de savoirs et de connaissances incalculables qui forment notre culture au sens anthropologique du terme. Tout au plus, pourrais-je, face à un article relatant un nouvel incident entre Israéliens et Palestiniens, suspendre temporairement mon adhésion à l'information présentée — quelle est la nature de l'incident ? qui sont les protagonistes ? quelles sont les conséquences ? — en attendant d'obtenir des informations complémentaires qui confirmeront ou infirmeront ce premier article. Mais, même dans ce cas, ces nouvelles informations ne seront pas réellement vérifiées mais simplement admises comme crédibles parce que congruentes.

L'injonction « penser par soi-même » [9] est en fait une injonction illusoire et même paradoxale : en effet, comment puis-je savoir en procédant à un tel exercice que je ne suis pas moi-même dans l'erreur ? Si la plupart des élèves font des erreurs multiples dans les démonstrations mathématiques, si la plupart d'entre nous faisons de grossières fautes de raisonnement et sommes victimes de multiples biais cognitifs [10], si les plus grands penseurs, scientifiques ou philosophes ont pu eux-mêmes se tromper ou s'égarer, comment prétendre que nous atteindrons la vérité par un effort intellectuel purement individuel ? Ou bien vais-je plus sûrement m'enfoncer dans mes propres erreurs prises pour des certitudes ? S'il y a eu progrès scientifique (même s'il n'est pas uniforme ni constant dans tous les domaines du savoir), c'est d'abord et avant tout parce que la science est une construction collective et qu'il y a un contrôle par les pairs, par d'autres scientifiques qui non seulement vérifient ce qui est affirmé mais qui ont établi des procédures multiples et de plus en plus contraignantes pour procéder à une telle vérification (procédures mathématiques, procédures logiques, procédures expérimentales…).

Le problème pour la plupart d'entre nous qui sommes plongés dans l'univers des médias n'est donc pas de faire preuve d'un « esprit critique » aussi vague qu'indéterminé, ni encore moins de faire montre de sa « liberté d'esprit » [11], mais consiste plutôt à répondre à des questions comme : qui peut-on croire ? à qui peut-on faire confiance ? La réponse que l'on essaiera de donner ici à ces questions ne se situera pas à un niveau abstrait ou principiel — « comment déterminer le vrai ? » — mais sera plutôt de nature sociologique et historique : sur quoi se fondent nos croyances aujourd'hui dans les sociétés dites développées qui, malgré d'importantes différences culturelles, partagent notamment un ensemble de conceptions communes de la vérité ?

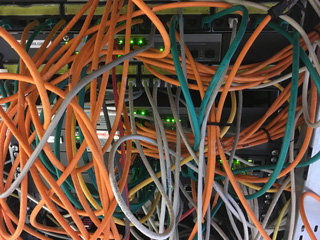

Les réseaux informatiques ont bouleversé l'accès à l'information

Une telle approche ne vise donc pas à « fonder » [12] nos croyances de manière catégorique en séparant le bon grain de la vérité de l'ivraie de l'erreur ou du mensonge mais à déterminer les raisons bonnes ou moins bonnes qui nous poussent à donner un crédit plus ou moins important aux différentes représentations médiatiques qui constituent l'essentiel de notre monde [13]. Cette approche ne prétend pas nous donner des certitudes absolues et elle laisse au contraire la place à l'erreur possible, à l'incertitude, au doute, mais aussi à des degrés de confiance plus ou moins grande. Enfin, elle doit rendre compte de l'absence de consensus, de la dispute au nom de conceptions différentes de la vérité, de la divergence des opinions et des évaluations face au monde. Dans un grand nombre de situations, nous devons en effet reconnaître que la vérité est indécidable et qu'il n'y a pas de critères « objectifs » qui nous permettent de faire un choix entre des affirmations ou des représentations concurrentes.

Face aux médias (définis de manière très vague), on peut de façon générale observer deux attitudes critiques opposées. La première consiste à affirmer leur caractère mensonger, orienté, partial qui s'expliquerait en particulier par leur soumission à des puissances extérieures (notamment aux pouvoirs politiques et aux grandes entreprises économiques). Dans cette optique, l'on dénoncera l'unanimisme supposé des médias, la « pensée unique » [14], le « conformisme », la « bien-pensance » ou encore le « politiquement correct ». Il y a une grande part de rhétorique dans cette posture qui permet de se poser en « esprit libre », en révolté ou même en persécuté de la bien-pensance : contrairement aux « moutons » baignant dans le conformisme et trompés par les médias, l'esprit éclairé, le « dissident » au regard critique révélerait la vérité cachée aux yeux de tous. Mais la dénonciation des préjugés idéologiques de l'adversaire masque souvent ses propres partis pris, et les accusations de conformisme (sinon de mensonge ou de mauvaise foi) seront facilement retournées par un adversaire d'un autre bord (l'extrême-droite politique critique ainsi de la même manière que l'extrême-gauche le supposé conformisme des médias, leur « bien-pensance », leur « déni de la réalité », même si cette réalité n'est évidemment pas la même pour les uns et pour les autres). Si la critique de certains médias (ou de certaines représentations médiatiques) est évidemment légitime, la généralisation de cette critique à l'ensemble des médias est beaucoup plus problématique parce que cette entité, les « médias », n'a pas de véritable unité : la presse américaine n'est sans doute pas la même que la presse française, allemande, russe ou chinoise ; la presse imprimée n'est pas la télévision qui ne se confond pas avec des blogs militants sur le web… En outre, s'il y a des mensonges ou des contre-vérités dans les médias, cela ne signifie pas qu'ils soient complètement faux : au contraire, comme on l'a montré avec le petit exemple du conflit israélo-palestinien, l'essentiel de nos connaissances du monde environnant a une origine médiatique. Enfin, s'il n'est pas possible d'échapper à tout parti pris idéologique, la véritable compréhension de ces enjeux nécessite sans doute, comme l'affirme le sociologue Pierre Bourdieu, de prendre en considération l'ensemble du champ (politique, culturel, universitaire… selon le cas) et des positions contrastées qui s'y manifestent : dit plus simplement, la dénonciation des partis pris d'autrui reste inefficace sans une réflexion sur sa propre position et ses propres prises de position qui en résultent [15].

La seconde attitude critique à l'égard des médias est plus radicale et aboutit à un scepticisme généralisé : « La vérité n'existe pas », « Toute vérité est subjective », « Tous des menteurs », « On ne saura jamais »… Le scepticisme généralisé n'est cependant pas une attitude pratiquement tenable : mes sens ne sont peut-être fiables, ils peuvent même me tromper en certaines occasions (comme les illusions d'optique), mais je ne pourrai pas laisser ma main sur un objet brûlant sous prétexte qu'il s'agirait peut-être d'une illusion ! Mais plus largement, à l'égard des médias et des opinions contradictoires qui s'y expriment, il n'est pas possible d'adopter une attitude constante de scepticisme ou de suspension de la croyance (« on ne sait pas… »), dans la mesure où nous sommes pris directement ou indirectement, volontairement ou involontairement, et surtout pratiquement dans certains de ces conflits : nous ne pouvons pas considérer de manière indifférente, avec scepticisme, comme n'étant ni vraies ni fausses, des opinions qui nous mettent personnellement en cause. Si certains pensent que les femmes sont inférieures aux hommes et qu'elles doivent leur être subordonnées, quelle femme (ou quel homme) peut considérer une telle opinion de façon neutre et indifférente ? Puis-je par ailleurs comme citoyen ou citoyenne soutenir un gouvernement qui serait accusé de mensonge ou de complot ? Pouvons-nous considérer avec indifférence et sans réaction les dangers possibles de l'industrie nucléaire, les effets catastrophiques du changement climatique ou les périls de la course aux armements entre grandes puissances ? Soit ces risques sont réels et importants, soit ils ne le sont pas, et notre attitude sera évidemment tout à fait différente dans un cas ou dans l'autre. Si l'on peut donc promouvoir, face au flux d'informations médiatiques, un scepticisme raisonnable consistant notamment à se détacher de l'émotion du moment et à suspendre temporairement un jugement qui pourrait être trop hâtif [16], un scepticisme absolu — qui prend souvent des formes paradoxales ou provocantes comme la formule de Jean Baudrillard affirmant en 1991 que « la Guerre du Golfe n'a pas eu lieu » et qu'on retrouve avec de multiples variantes dans ce qu'on appelle la philosophie « postmoderne » —, est une position intellectuellement abstraite qui ne correspond pratiquement à aucune expérience réelle : on peut débattre des causes, des conséquences, du déroulement de la Guerre du Golfe mais personne ne doute qu'elle a bien eu lieu même si l'on n'en a pas eu une expérience directe mais seulement une connaissance via les médias aussi « trompeurs », manipulateurs et orientés soient-ils.

Ce que nous considérons comme la vérité a une histoire qui varie selon les sociétés, les cultures (au sens anthropologique du terme), les régions du monde ou même les individus. Il y a quelques siècles encore en Occident, la Bible était considérée comme une autorité légitime pour connaître l'origine du monde. Ce n'est évidemment plus le cas aujourd'hui à l'exception de quelques esprits religieux minoritaires [17]. Aujourd'hui, la science joue sans doute ce rôle d'autorité incontestable en matière de vérité. Cela ne signifie pas que nous admettions sans discussion toutes les affirmations de nature scientifique mais que la référence à la Science (articles, professeurs, chercheurs, savants, grandes figures comme Einstein, Pasteur ou Newton…) est censée garantir la vérité de nos affirmations et mettre fin ainsi aux querelles partisanes (même si, dans les faits, un tel recours à l'autorité scientifique est le plus souvent battu en brèche par la référence à d'autres autorités scientifiques…).

Mais pourquoi accordons-nous un tel crédit à la science ? Bien entendu, nous [18] avons tous reçu au cours de notre scolarité une éducation scientifique, mais l'on doit bien reconnaître que la plupart d'entre nous n'avons qu'une maîtrise très sommaire et très partielle des différents domaines scientifiques, et que nous sommes pour la plupart incapables d'expliquer les lois de Kepler ou de comprendre la théorie de la relativité restreinte d'Einstein. Et, si nous avons tous entendu parler des trous noirs, qui pourrait en donner une définition exacte et surtout prouver leur existence à la fois de façon théorique et par l'observation ? Et qui, dans le domaine de la vie quotidienne, peut expliquer de façon précise la différence entre glucides, lipides et protéines dont on retrouve les dénominations sur la plupart des emballages alimentaires ? Pourquoi alors accordons-nous un tel crédit à la science ?

Avant de répondre à ces questions, on relèvera encore le paradoxe suivant : les mots et les concepts de la science, qu'il s'agisse par exemple du réchauffement climatique, du Sida, de la surpopulation, de l'autisme, des vitamines, des toxines, du Big Bang, de l'infarctus du myocarde, de la sélection naturelle ou encore de l'inflation, qui sont au départ des notions spécialisées, précisément définies (en principe), sont repris par le public profane, notamment les journalistes, généralement de manière approximative, parfois polémique, pour penser et agir dans le monde : les personnes ayant une sensibilité écologique essaieront de réduire leur production de gaz à effet de serre même s'ils sont incapables d'expliquer pourquoi le CO2 est précisément une des causes du réchauffement climatique. Les sciences constituent donc des domaines réservés à certains spécialistes (qui en maîtrisent en principe les règles et le fonctionnement) mais elles font également partie de notre vie quotidienne et notamment de la représentation que nous nous faisons du monde environnant. Les « mots » de la Science deviennent (pour un certain nombre d'entre eux) des mots communs même s'ils perdent alors une grande partie de leur précision sinon de leur sens.

Pour comprendre le crédit que nous accordons à la « Science », il faut sans doute faire une distinction entre les sciences dites dures ou exactes (mathématiques, physique, chimie, biologie…) et les sciences « molles » (essentiellement les sciences humaines), en précisant tout de suite que cette distinction est sommaire et aussi discutée que discutable au niveau épistémologique. Mais il est clair que la plupart d'entre nous croirons plus facilement les affirmations d'un astrophysicien (parlant d'astrophysique…) que d'un sociologue ou d'un psychologue.

L'image commune des « sciences exactes » trouve certainement son origine dans la révolution copernicienne en astronomie et ses suites dans le domaine général de la physique (avec notamment la grande synthèse newtonienne). Elle repose sur la conviction que la « nature » obéit à des lois universelles (comme celle de l'attraction) qui peuvent être formulées de façon mathématique. Ces lois sont donc le fruit de raisonnements qui s'appuient par ailleurs sur l'expérience et notamment sur la mesure de faits ou phénomènes dont l'observation peut être répétée. Les sciences exactes permettent dès lors de prédire certains phénomènes, qu'il s'agisse d'éclipses lunaires, de réactions chimiques ou de la guérison d'un malade par des doses adéquates d'antibiotiques.

Cette conception désormais classique des lois de la nature a sans doute été transformée par les progrès mêmes des différentes sciences comme la célèbre théorie de la relativité d'Einstein qui a montré que la physique newtonienne (par exemple la deuxième loi de la dynamique qui dit que l'accélération est proportionnelle à la force ou la somme des forces appliquées à l'objet et inversement proportionnelle à sa masse) était seulement une approximation qui ne se vérifie que pour des objets dont la vitesse est faible par rapport à celle de la lumière [19]. L'épistémologie contemporaine (illustrée notamment par Karl Popper [20]) met dès lors l'accent sur le fait que les théories scientifiques sont des modèles qui ne doivent pas être considérés comme des « lois » universelles et intemporelles cachées dans la nature des choses (qu'il suffirait dès lors de découvrir une fois pour toutes) : ce sont des constructions symboliques complexes et extrêmement élaborées dont la validité est sans doute très grande mais ne peut être définie comme absolue.

Ces nuances ne modifient cependant pas de manière profonde la conception la plus courante que nous avons des sciences exactes, ni du crédit que nous accordons très généralement aux « découvertes » de la science. Sur quoi s'appuie alors un tel crédit ? Quelles bonnes raisons avons-nous de croire que la terre est ronde, que la vitesse de la lumière est de 300 000 kilomètres par seconde, que l'univers est en expansion depuis le « Big Bang » ou que l'espèce humaine est apparentée aux grands singes et descend d'un ancêtre commun ?

On peut distinguer deux grands types de raisons qui justifient notre croyance en la vérité des sciences exactes.

Le premier type correspond aux raisons invoquées traditionnellement par les scientifiques eux-mêmes. Ainsi, les sciences exactes se basent sur des démarches qualifiées de rationnelles, dont l'outil mathématique est le meilleur exemple et qui se signalent par le caractère explicite de chaque étape de leurs raisonnements. Bien entendu, il s'agit là d'un idéal scientifique qui ne correspond pas nécessairement à la réalité des démarches scientifiques où l'on rencontre erreurs, approximations, conclusions hasardeuses, fraudes et mensonges parfois.

Par ailleurs, les sciences exactes pratiquent l'expérimentation dont les procédures (notamment la répétition des expériences dans les mêmes conditions) garantissent la validité des théories. L'expérimentation mêle de façon complexe induction, hypothèse, déduction et vérification, mais elle constitue la base objective des sciences comme la physique, la chimie ou la biochimie (contrairement aux mathématiques ou à la logique qui reposent uniquement ou essentiellement [21] sur des raisonnements). Au-delà de l'expérimentation proprement dite, les sciences (notamment la biologie, la médecine, la géographie, l'astronomie…) pratiquent de façon importante l'observation qui fournit une masse de données empiriques vérifiées même si toutes ces données ne font pas l'objet d'une interprétation dans le cadre d'une théorie hypothético-déductive : la géographie par exemple a d'abord consisté en l'élaboration de cartes aussi précises que possible bien avant d'envisager la question de la dérive des continents. Et ce type d'observations a permis d'établir l'existence d'animaux aussi étranges que l'ornithorynque ou le ptérodactyle tout en rendant très improbable celle du centaure ou de la licorne…

Ces deux démarches — raisonnement et observation —, même si elles ne coïncident pas exactement, entraînent une grande cohérence dans les différents domaines scientifiques. Toute nouvelle découverte scientifique s'inscrit dans un cadre de connaissances déjà établies qu'elle va compléter ou, beaucoup plus rarement, révolutionner : la relativité d'Einstein a profondément modifié certains fondements de la physique classique (comme l'évidence supposée que le temps serait une constante) mais elle permettait de résoudre une série de contradictions apparues dans les différents champs de la physique (comme le fait que la vitesse de la lumière était une constante indépendante de la vitesse de sa source) tout en respectant son cadre mathématique. C'est la cohérence nouvelle de la synthèse d'Einstein qui a d'ailleurs convaincu la majorité des autres physiciens de sa validité avant même toute confirmation expérimentale. De manière générale, l'on constate donc un progrès dans les différentes sciences, même s'il n'est pas uniforme et varie grandement selon les domaines et selon les moments : conflits et contradictions sont également bien présents [22] même si les scientifiques partagent le même cadre général de connaissances dans leur domaine, et que le progrès consiste précisément en la résolution de ces contradictions.

Il y a enfin un critère pratique à l'œuvre dans les différents champs scientifiques, bien qu'il soit rarement explicité en tant que tel : il s'agit tout simplement du contrôle par les pairs — les autres scientifiques du domaine — qui s'exerce notamment à travers les comités de lecture dans les revues scientifiques, destinés à valider les articles qui leur sont soumis. Ce contrôle peut prendre du temps et certaines théories, par exemple celles de Newton ou de Darwin, ont mis des années et parfois des décennies avant d'être universellement admises. Et l'unanimité n'est pas nécessairement signe de vérité : jusqu'à Copernic (sinon au-delà), les astronomes ont cru évidemment que c'était le soleil (et l'ensemble des astres) qui tournait autour de la terre et non l'inverse… Mais c'est le contrôle par les pairs qui permet aux différentes sciences de former un ensemble de connaissances cohérentes, vérifiées, transmissibles et dès lors susceptibles de progrès.

Mais pour quelles raisons les non-scientifiques accordent-ils du crédit aux sciences « exactes » ? Sans doute, l'école, dont on a souligné le rôle important en la matière, prédispose largement à cette croyance (fondée essentiellement sur l'autorité des maîtres et qui n'est que partiellement rationnelle vu la faible compétence scientifique de la majorité des élèves). Mais d'autres « raisons » justifient notre croyance en la « Science », même si cette croyance n'est pas absolue et si cette Science idéale ne se confond pas nécessairement avec les sciences effectives dont les résultats peuvent être partiels, hypothétiques ou conflictuels.

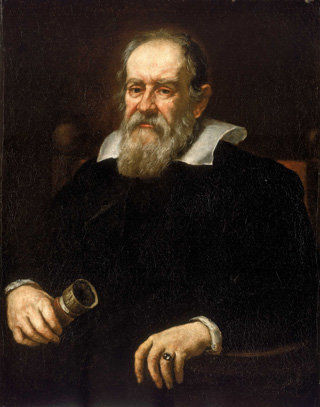

Un portrait de Galilée (1564-1642)

qui a profondément transformé l'ancienne vision du monde

Une raison essentielle de ce crédit aux yeux du public non-scientifique réside sans doute dans le fait que les sciences exactes révèlent des « réalités » ou des vérités inédites, inattendues, originales et d'une singulière complexité. La révolution copernicienne est l'exemple type de vérité qui contredit l'intuition commune ; mais, pour affirmer une telle vérité à contre-courant de l'opinion générale, il fallait évidemment des raisons extrêmement fortes capables d'emporter l'adhésion des savants. Semblablement, la relativité d'Einstein, qui contredit de façon si profonde notre conception intuitive du temps et de l'espace, n'a pu s'imposer à l'ensemble des physiciens que par la cohérence et la rigueur de ses démonstrations (auxquelles s'ajoutent des confirmations expérimentales postérieures). Les sciences bouleversent donc notre vision spontanée des choses en y important des entités multiples dont nous ne pourrions jamais avoir l'intuition spontanée et que nous ne pourrions même pas imaginer : l'on voit ainsi facilement la différence profonde entre l'atomisme de Démocrite pour qui l'atome est le plus petit élément insécable de la matière (ce qui est facile à comprendre) et les conceptions physico-chimiques actuelles qui distinguent protons, neutrons et électrons (sans compter des particules encore plus élémentaires comme les quarks ou les leptons). Semblablement, les sciences nous ont révélé l'existence d'entités comme les virus, les naines blanches (en astronomie), les lipides, les équations différentielles, les hormones, la tectonique des plaques, les enzymes ou la radioactivité dont spontanément et intuitivement nous n'avons pas la moindre idée : il est évidemment difficile sinon impossible pour un profane de discuter de telles entités ou de tels phénomènes, même en recourant à différentes formes de vulgarisation, mais, à défaut d'autres explications, nous n'avons pas non plus de raisons de douter de leur validité scientifique.

En outre, et c'est sans doute plus évident aux yeux des profanes, les sciences exactes trouvent une évidente confirmation de leur justesse dans l'ingénierie et les applications pratiques qui en sont faites : tout le monde sait qu'il n'est pas possible d'envoyer une fusée dans l'espace sans de solides connaissances en physique, même si ce sont des bricoleurs de génie (non dépourvus d'ailleurs de telles connaissances) qui ont construit les premiers objets volants. Médicaments, chirurgie, moteurs, avions, constructions de toutes sortes, électricité, électronique, télévision, ordinateurs, informatique, bombes atomiques… quoi qu'on pense que de toutes ces inventions, nous sommes évidemment persuadés qu'elles n'auraient pas été possibles sans une masse énorme de connaissances scientifiques que, pour la plupart d'entre nous, nous ne maîtrisons pas. Et inversement, l'on suppose que les connaissances scientifiques sont validées (au moins en partie) par ces multiples applications pratiques. Je suis incapable de comprendre comment fonctionne mon téléphone portable, et je dois dès lors supposer que ceux qui l'ont construit disposent de savoirs suffisamment solides pour qu'un tel objet complètement artificiel fonctionne correctement. Et si l'électronique est une science « exacte » comme me le montre l'existence de ce téléphone, comment pourrais-je douter de la vérité de la physique entière ?

Faut-il dès lors toujours croire les experts scientifiques ? Ce serait sans aucun doute naïf, et l'expertise scientifique peut effectivement être mise en doute pour différentes raisons.

On remarquera d'abord que les sciences considérées comme « exactes » comprennent des « zones » de conflit, d'incertitude, de divergence : il y a par exemple en astrophysique de nombreux objets théoriques comme les trous blancs, les trous de ver ou les trous noirs de Reissner-Nordström qui sont considérés comme très hypothétiques. Même le Big Bang, qui est largement accepté comme modèle cosmologique, reste méconnu dans sa phase initiale (ce qu'on appelle l'ère de Planck) pour laquelle les lois connues de la physique ne s'appliquent plus. En outre, beaucoup de domaines scientifiques utilisent des modèles statistiques ou probabilistes [23] qui, comme leur nom l'indique, déterminent la probabilité de survenue d'un événement mais ne peuvent pas le prévoir avec certitude : les lois de la génétique constituent une avancée majeure de la biologie, mais elles permettent seulement de prédire que si les deux parents sont porteurs du même gène récessif, il y a une chance sur quatre que ce caractère récessif s'exprime chez l'enfant ; semblablement, l'on sait aujourd'hui que le sexe de l'enfant est déterminé par les spermatozoïdes du père (et non par l'ovule de la mère), mais cela ne nous permet pas de prédire le sexe de l'enfant avant la conception, sinon de façon probabiliste (le sex ratio à la naissance est approximativement de 105 garçons pour 100 filles).

Beaucoup de savoirs scientifiquement fondés constituent en fait des approximations (de nature statistique ou non) et ne peuvent donc pas être considérés comme exacts au sens courant du terme. Un exemple simple est celui de la météorologie qui rend compte d'un grand nombre de phénomènes (pluie, ouragans, tornades ou plein soleil…) grâce à des concepts clairement définis (basses et hautes pressions, températures de l'air ou des océans, sens de rotation d'un anticyclone différent dans l'hémisphère nord et dans l'hémisphère sud…), mais dont les prévisions sont limitées (à cinq jours à peu près) et peu précises, du moins du point de vue du piéton surpris par une averse inattendue… Un autre exemple est celui de la pharmacologie où l'on pratique des études randomisées en double aveugle [24] qui garantissent l'efficacité des médicaments, mais, dans la plupart des cas, cette efficacité n'est pas totale : tous les malades ne guérissent pas, ou certains ne guérissent pas plus rapidement que sans médicamentation (toutes les maladies ne sont heureusement pas mortelles…). Le point de vue scientifique, qui constate une efficacité significative, doit être alors distingué du point de vue du patient individuel qui constate que le médicament ne le guérit pas.

Par ailleurs, les modèles scientifiques, qui mettent en évidence les « lois » ou les régularités dans le monde, constituent des abstractions qui sont parfois très éloignées de la réalité concrète : l'on sait bien que, selon les lois de l'attraction, deux corps de même masse chutent à la même vitesse, mais l'on sait aussi qu'à cause du frottement de l'air, une feuille de papier descend beaucoup plus lentement qu'une pomme tombant de l'arbre sur la tête du physicien ! Toute approche scientifique d'un phénomène concret est donc partielle et néglige des aspects de la réalité considérés comme secondaires, négligeables ou aléatoires (du moins dans la perspective adoptée). Cela peut cependant poser des problèmes notamment dans l'ingénierie et dans toutes les applications scientifiques : même bien construits, certains ponts s'écroulent, des avions s'écrasent, et quatre réacteurs de la centrale de Fukushima ont explosé suite à un tsunami dont la violence n'avait pas été prévue. En dehors des accidents qui peuvent sembler imprévisibles (même s'ils ne le sont pas tous), nombre d'applications scientifiques suscitent des interrogations légitimes car elles ne prennent en compte qu'un aspect de la problématique concernée : l'énergie nucléaire ne sait pas que faire de ses déchets, les pesticides (ou au moins certains d'entre eux) ont des effets durables et sans doute indésirables sur l'environnement mais également sur la santé humaine, les moteurs à explosion sont une des causes du réchauffement climatique… Dans les problèmes pratiques et concrets, l'on se trouve donc souvent confrontés à des querelles d'experts qui se disputent sur l'origine ou la cause du problème, et parfois même sur sa nature ou sa réalité.

Enfin, l'autorité des scientifiques dépend largement de leur domaine d'expertise alors même que la distinction entre sciences « exactes » et sciences « molles » est, comme on l'a déjà noté, très floue : peu de personnes mettent en doute l'astrophysique ou la chimie en tant que sciences ; en revanche, l'économie, qui recourt pourtant grandement aux mathématiques, peut-elle prétendre au même statut ? La médecine, dont les découvertes sont indéniables, est-elle entièrement scientifique [25] ? L'histoire est-elle une science comparable à la paléontologie ? Le recours aux statistiques garantit-il la scientificité de la sociologie, de la démographie ou de la climatologie ? ou seulement de certaines de leurs recherches ? Quel est le statut scientifique de la linguistique ? Et pourquoi la théorie de l'évolution de Darwin est-elle considérée comme scientifique alors qu'elle n'est pas de nature prédictive et ne s'appuie pas sur la méthode expérimentale (ou hypothético-déductive) ?

On soulignera encore le fait que les concepts scientifiques ou du moins certains d'entre eux peuvent passer dans le langage courant et être utilisés par des personnes dont la compétence scientifique est plus faible : des concepts spécifiquement définis comme le Big Bang, les hormones, les enzymes, les vitamines, l'adrénaline, l'espace-temps, les ondes, les neurones etc. sont largement utilisés par des profanes, parfois de façon complètement détournée (comme les enzymes vantées à une époque par la publicité comme des agents de lavage du linge). Très souvent, de tels concepts manipulés par des pseudo-spécialistes fonctionnent ainsi comme des arguments d'autorité, ce qui peut susciter un scepticisme légitime mais aussi une crédulité infondée : la découverte des vitamines et de leur rôle dans certaines maladies graves — comme le scorbut provoqué par un manque de vitamine C ou le rachitisme dû à une carence de vitamine D — a ainsi entraîné la production d'aliments « enrichis en vitamines », bien que les nutritionnistes s'interrogent sur les bénéfices réels d'un tel enrichissement et conseillent plutôt un équilibre alimentaire général. La mode a d'ailleurs changé, et c'est à présent les minéraux (fer, calcium, magnésium…) et les oligoéléments qui sont vantés dans ces produits enrichis sans que leur efficacité (sinon même leur innocuité) ne soit prouvée.

En tant que profanes, nous avons certainement de bonnes raisons de croire en l'autorité de la « Science » (et en particulier des sciences exactes), mais cette autorité n'est évidemment pas absolue et mérite dans un certain nombre de situations d'être interrogée. Mais comment alors mener une telle réflexion critique et ne pas céder à un doute déraisonnable ? L'on comprend immédiatement qu'il serait absurde de vouloir proposer une « méthode » critique qui permettrait de juger — dont ne sait où ? et l'on ne sait comment ? — de la vérité des choses alors même que les experts, réels ou supposés, ne sont pas d'accord entre eux. La vérité, on l'a dit, est une construction historique, et il serait vain de prétendre la refonder grâce à notre seul « esprit critique » (ou à toute autre compétence de nature rationnelle).

On donnera donc seulement ici deux exemples de réflexions qui permettent de fonder ce qu'on pourrait appeler une croyance raisonnable (dans des domaines qui relèvent plutôt des sciences exactes), tout en conservant à l'esprit que cette croyance se révélera peut-être fausse à l'avenir (même si cela nous paraît peu vraisemblable…).

Le réchauffement climatiqueLe réchauffement climatique est un sujet d'actualité débattu, même si l'on remarque des contrastes parmi les opinions publiques des différents pays : la majorité des Européens croient bien que l'humanité est responsable du réchauffement en cours (plus de 80% des sondés en France [26]), alors qu'aux États-Unis, seuls 47% des sondés pensent que les activités humaines sont responsables du changement climatique (dont 63% reconnaissent l'existence mais sans nécessairement pointer la responsabilité humaine) [27]. Les « climatosceptiques » constituent donc une minorité relativement significative, parmi lesquels se trouve, on le sait, l'actuel président des États-Unis, Donald Trump. Ces personnes sont-elles des esprits « libres », « critiques », des résistants à « l'orthodoxie » scientifique, des anti-dogmatiques face à la conspiration des crédules ? Ou bien la majorité de l'opinion publique a-t-elle raison de croire au réchauffement climatique ? C'est bien à ces raisons de croire à ce phénomène qu'on va à présent s'attacher sans prétendre apporter une nouvelle fois les preuves scientifiques (que l'on ne maîtrise d'ailleurs pas, n'étant pas climatologue de formation) de sa réalité. Le réchauffement est au départ une hypothèse scientifique [28] qui trouve son origine dans une intuition ancienne : l'atmosphère joue un rôle essentiel dans la température clémente de la terre qui n'absorbe pas toute la chaleur reçue du soleil (sinon elle deviendrait beaucoup plus chaude qu'elle ne l'est) mais n'en renvoie pas non plus la totalité vers l'espace (sinon elle serait beaucoup plus froide). L'atmosphère a un effet similaire à une serre qui retient une partie de la chaleur reçue du soleil. Il ne s'agissait que d'une intuition (de Joseph Fourier vers 1820) indémontrable à l'époque mais qui s'est transformée ensuite en hypothèse scientifique : les changements dans la composition de l'atmosphère pouvaient-ils expliquer les variations du climat de la terre dont on avait de multiples traces (notamment les âges glaciaires) ? Dès la fin du 19e siècle, un scientifique fait l'hypothèse que le CO2 dont la teneur évolue lentement au cours du temps pourrait être le facteur explicatif de ces changements. Il s'agissait cependant d'une hypothèse difficile à vérifier, étant donné la complexité de l'atmosphère terrestre constituée de multiples couches et de ses interactions avec d'autres éléments terrestres comme les océans ou la biosphère (qui absorbent une partie du CO2). De nombreuses recherches théoriques — aux résultats contradictoires — apportaient par ailleurs de nouvelles connaissances notamment sur l'absorption du rayonnement infrarouge par les différentes couches de l'atmosphère. Des recherches à la fois théoriques et expérimentales mirent en outre en évidence dans les années 1950 qu'une partie du carbone fossile utilisé par les activités humaines (bois, charbon, pétrole…) s'accumulait bien dans l'atmosphère et n'était pas absorbée par les océans. D'autres recherches menées grâce à des carottages très profonds dans l'Antarctique [29] allaient (dans les années 1980) permettre de suivre de façon beaucoup plus nette l'évolution du climat au cours des 150 000 dernières années et montrer que la succession des périodes glaciaires et interglaciaires correspondait à l'évolution de la concentration de CO2. Toutes ces recherches théoriques et expérimentales devaient cependant être confirmées par des observations de l'évolution récente du climat pour prouver que les rejets de gaz carbonique (mais également de méthane) par l'activité humaine depuis plus d'un siècle produisaient effectivement un réchauffement climatique. Cela suppose une quantité importante d'observations dans toutes les régions du monde et sur une longue période de temps (généralement depuis le début du 20e siècle) : il ne faut évidemment pas confondre l'évolution du climat global de la terre avec la météo locale qui est soumise à de grandes variations locales et temporelles. Il peut y avoir un hiver rigoureux exceptionnel dans une région donnée, mais cela ne signifie pas qu'il n'y a pas de réchauffement climatique global, et bien entendu, l'inverse n'est pas vrai non plus : il faut calculer les moyennes de température en un grand nombre d'endroits sur une longue période et « lisser » les courbes pour apercevoir une évolution d'ensemble. À l'échelle de la planète, l'augmentation de la température peut sembler très faible — 0,9 °C entre 1901 et 2012 selon une estimation du GIEC —, mais l'augmentation est régulière depuis les années 1960. Des signes — qui ne peuvent pas être considérés comme des preuves indubitables — du réchauffement climatique sont facilement perceptibles (avec les moyens d'observation modernes) comme la diminution de la surface de la banquise arctique ou le recul de la majorité des glaciers de montagne. Bien entendu, l'évolution future du climat donne lieu à de multiples hypothèses même si toutes concluent à une augmentation de la température moyenne : c'est l'ampleur de ce réchauffement qui varie selon les modèles, ainsi que l'importance de ses conséquences (l'augmentation de la température entre la période actuelle et 2100 est estimée entre 0,3 °C par les plus optimistes et 3,1 ou 4,8 °C par les plus pessimistes). Recherches théoriques et expérimentales ainsi que des observations multiples, qu'on a brièvement évoquées [30], concordent donc largement pour à la fois constater le réchauffement climatique actuel et l'attribuer essentiellement aux activités humaines. Cet accord se manifeste au niveau scientifique entre la grande majorité des experts dont les recherches et les publications dans des revues scientifiques concluent au réchauffement climatique depuis plus d'un demi siècle et au rôle essentiel des activités humaines dans ce phénomène. Différentes études ont même été menées pour mesurer l'importance de ce consensus qui s'élèverait à plus de 90% parmi les spécialistes du climat [31]. L'on peut dire qu'il s'agit là d'une raison essentielle pour les profanes de croire en la réalité de ce phénomène. Comment expliquer alors qu'une minorité importante d'Américains mais aussi d'Européens continuent à croire le contraire ? Il faut sans doute distinguer chez les personnes sceptiques celles qui nient le réchauffement climatique et/ou la responsabilité des activités humaines, et celles qui dans des sondages d'opinion choisissent la réponse neutre : « Je ne sais pas ». Après tout, il est normal qu'un certain nombre de personnes, n'ayant pas de compétences scientifiques, renoncent à se faire une opinion et à donner un avis tranché (qu'elles ne pourraient pas étayer face à des contradicteurs) : on pourrait parler ici d'un doute raisonnable. En revanche, un certain nombre de personnes, dont des scientifiques (même si ces scientifiques sceptiques sont très rarement des spécialistes de la climatologie), nient fermement la réalité du réchauffement climatique ou l'attribuent à d'autres causes. Ces climatosceptiques mettent alors en cause l'indépendance des chercheurs (financés par les États), les intérêts financiers des industriels « verts », le goût des médias pour les catastrophes… Mais il est peu vraisemblable qu'un accord aussi large entre des scientifiques venus de pays et d'horizons aussi différents s'explique par des raisons aussi faibles et aussi diverses ; il serait également étonnant que des hommes politiques (si l'on excepte Donald Trump) acceptent de prendre des décisions impopulaires qui impliquent une modification de nos modes de vie pour ce qui ne serait qu'une illusion scientifique. Pourquoi ces climatosceptiques persistent-ils alors dans leurs croyances ? (car ils n'ont pas bien sûr plus de certitudes scientifiques que la plupart des profanes.) Deux raisons expliquent sans doute leur position (si l'on excepte celles qui motivent les industriels des énergies fossiles). La première est que la réalité du changement climatique impose une transformation peut-être difficile de nos modes de vies, nous imposant d'être plus économes dans notre consommation énergétique [32]. Par ailleurs, ce phénomène à cause de ses conséquences potentielles est relativement angoissant : certaines prévisions peuvent sembler catastrophiques sinon catastrophistes, et l'on peut préférer ne pas voir la « réalité » en face en invoquant l'incertitude des connaissances scientifiques. Mais il s'agit bien plus d'une incertitude de principe — rien n'est certain — que d'un doute raisonnable. Celui-ci ne porte que sur l'ampleur du phénomène à l'avenir et sur ses conséquences possibles. |

* *

*

L'épidémie du Sida et l'action militanteLe deuxième exemple envisagé est très différent du précédent puisqu'il porte sur la réaction de groupes de malades du Sida (et de leurs proches) devenus des militants dans la lutte contre l'épidémie à travers des associations comme Act Up-Paris [33]. Mais il faut d'abord rappeler le contexte où est apparu cette maladie, même si l'histoire de la pandémie du sida est certainement fragmentaire et reste à faire. Il faut en particulier rappeler les incertitudes de l'époque. C'est en juin 1981 que le CDC (Centers for Disease Control and Prevention), la principale agence de santé publique aux États-Unis rapporte dans une revue médicale cinq cas de pneumocystose chez des homosexuels à Los Angeles : c'est une première alerte car cette forme rare de pneumonie ne se développe que quand les défenses naturelles de l'organisme sont diminuées, et elle n'affecte donc pas en principe des hommes jeunes et en bonne santé. Dans les mois qui suivent, d'autres cas sont signalés, tous caractérisés par une immunodépression sévère (la perte des défenses naturelles de l'organisme contre les infections opportunistes), et les spécialistes nomment bientôt cette nouvelle maladie sida (aids en anglais) pour Syndrome d'Immuno-Déficience Acquise : ce dernier qualificatif est important puisqu'il signifie que, bien que l'on n'en connaisse pas encore la cause, ce syndrome n'est pas de nature génétique ou héréditaire et résulte très vraisemblablement d'un agent pathogène (virus, bactérie, parasite…). Au début des années 1980, la nature infectieuse de la maladie (d'abord faussement appelée « cancer gay ») est donc perçue par les personnes ayant un minimum de connaissances médicales, mais les modes de transmission sont alors inconnus ou mal connus même si l'on peut penser qu'il s'agit d'une infection sexuellement transmissible. Dans ce contexte, les premiers conseils de prévention apparaissent sans que leur efficacité ne soit prouvée, même si aujourd'hui, les trois grands modes de transmission sont bien connus (rapports sexuels non protégés ; utilisation d'un matériel, comme des seringues, contaminé ; transmission mère-enfant, pendant la grossesse, l'accouchement et l'allaitement), et que des interrogations ont pu subsister pendant un temps assez long suscitant certaines craintes non fondées (les moustiques par exemple ne transmettant pas le virus qui ne survit pas dans leurs glandes salivaires [34]). On sait également qu'il n'y a pas de transmission par les larmes, la sueur, la salive, la toux ou les éternuements, ni par les poignées de mains, les baisers, les massages ou la masturbation. Enfin, lors des rapports sexuels, l'utilisation de préservatifs constitue la meilleure protection. De grandes incertitudes ont néanmoins entouré la découverte du virus en 1983 et l'apparition des premiers tests en 1985 : on ne connaît pas alors la proportion de personnes séropositives (sans symptômes graves) qui développeront le sida, et certains croient — erronément, on le sait aujourd'hui — qu'il ne s'agit que d'une minorité (on parle de 5 ou 10%, les autres étant faussement qualifiés de « porteurs sains »). L'annonce de la séropositivité (à partir du moment où les tests seront disponibles) est dans ce contexte extrêmement angoissante puisque la personne contaminée ne sait pas si elle va développer la maladie ni quand. Dans le milieu gay des grandes villes, chacun constate en outre que la maladie frappe mortellement l'une ou l'autre connaissance : cette proximité avec la maladie et son issue mortelle est une expérience marquante sinon traumatisante pour des jeunes gays confrontés à l'indifférence (plus ou moins importante) de la société environnante. Dans ce contexte, certaines personnalités vont, pour secouer l'opinion publique, révéler qu'elles sont atteintes du sida : c'est le cas notamment de l'acteur hollywoodien Rock Hudson qui meurt en 1985 quelques mois après sa révélation, du tennisman afro-américain Arthur Ashe qui s'est activement engagé dans la lutte contre le sida jusqu'à son décès en 1993, ou encore de Freddie Mercury, le chanteur du groupe Queen, qui déclarera à la veille de sa mort en novembre 1991, être infecté par le vih (reconnu alors comme le virus responsable de la maladie). Si beaucoup d'autres artistes et écrivains font des annonces similaires, d'autres préfèrent se taire sans doute à cause de l'opprobre qui touche alors les malades. Il faut également rappeler le scandale du sang contaminé qui frappe à ce moment la France. Dès janvier 1984 [35], l'on découvre que les transfusions sanguines sont une source possible de contamination, et à la fin de la même année, l'on sait que le chauffage d'extraits du plasma inactive le virus. Mais cette technique américaine n'est pas maîtrisée ou est négligée en France, les autorités refusant en outre d'importer des poches chauffées de l'étranger. Pourtant, dès mars 1985, les responsables du CNTS (Centre National de Transfusion Sanguine) savent que les poches de sang qu'ils distribuent sont certainement contaminées. Puis, en avril, le secrétariat à la Santé pousse à surseoir l'autorisation d'un test américain pour protéger les intérêts de l'institut Pasteur qui est en train d'élaborer son propre test. En outre, alors que les premiers tests au vih sont enfin autorisés en juin 1985, les centres de transfusion sanguine vont continuer à distribuer des stocks de poches non testées jusqu'à la fin de l'année. Les hémophiles, à qui l'on transfuse régulièrement des poches de sang, sont largement contaminés (on parle de 50% d'entre eux) et un grand nombre vont mourir dans les années qui suivent. Ces quelques mois de retard [36] dans l'utilisation de poches chauffées et dans la mise en œuvre de tests coûteront sans doute la vie à des centaines de personnes. Ce scandale entraînera différents procès à l'encontre de médecins responsables du CNTS (dont quatre seront effectivement condamnés) et de responsables politiques (un seul sera condamné). Jusqu'au milieu des années 1980, l'incertitude est donc grande quant aux modes de transmission mais également quant aux soins possibles, aux médicaments ou à un possible vaccin. À cause de l'urgence sanitaire, des médecins (mais aussi des charlatans) feront des déclarations précipitées, mettant en avant l'un ou l'autre médicament susceptible d'agir contre le sida. Ce sera le cas notamment de la ciclosporine, un médicament utilisé jusque-là dans le cadre de la transplantation d'organes, que trois médecins français, sous l'égide du ministère des affaires sociales (en charge de la santé), présentent lors d'une conférence de presse en octobre 1985 comme un remède possible sur base d'un essai thérapeutique sur deux malades seulement (qui mourront par la suite). Très rapidement, cette annonce se révélera fausse, tout en suscitant des polémiques parmi les médecins comme parmi les journalistes qui ont ou non relayé l'information (aujourd'hui encore, les annonces concernant un possible vaccin sont fréquentes). Le premier véritable médicament efficace, l'AZT (synthétisé en 1964 comme anticancéreux), sera utilisé pour le traitement de la maladie à partir de 1987, mais, s'il prolonge effectivement la durée de vie, il n'arrête pas réellement la maladie et entraîne de multiples effets secondaires négatifs (maux de tête, nausées, anémie…). Ce n'est qu'en 1996 qu'apparaissent les trithérapies, qui associent comme leur nom l'indique trois médicaments et qui diminueront fortement la mortalité du sida tout en améliorant la qualité de vie des patients. On ne parle cependant pas de guérison car les malades doivent continuer le traitement sans interruption. Ces trithérapies ou multithérapies (associant parfois quatre ou cinq substances) varient en fonction essentiellement des réactions plus ou moins positives des patients. Enfin, cette épidémie que certains croyaient d'abord localisée aux États-Unis ou dans quelques pays occidentaux seulement, touche en réalité le monde entier. Elle frappe massivement des pays pauvres en Asie et en Afrique. En 2001, l'ONU estime ainsi que « plus de 36 millions de personnes dans le monde vivent avec le vih/sida, et plus des deux tiers de cette population infectée sont en Afrique subsaharienne »[37], provoquant dans plusieurs de ces pays un recul de l'espérance de vie (Botswana, Kenya, Lesotho, Namibie, Afrique du Sud, Swaziland, Zambie et Zimbabwe). Cette inégalité géographique est pour une part la conséquence d'une inégalité sociale et économique qui se traduit notamment par de nettes différences d'accès aux soins et aux moyens de prévention. Ce rappel un peu long est sans doute nécessaire pour comprendre l'action d'associations comme Act Up-Paris mais également Aides, Arcat Sida ou Vaincre le sida, dans un climat à la fois d'incertitude et d'urgence pour les malades. À qui faire confiance ? En quelles recherches mettre ses espoirs ? Jusqu'à quel point faire confiance alors que certains scientifiques font eux-mêmes des annonces prématurées se révélant bientôt erronées ? Deux stratégies médicales [38] sont alors en présence : d'une part, la tradition clinique privilégie le médecin individuel qui évalue l'effet de ses prescriptions médicales sur chaque patient ; d'autre part, ce qu'on peut appeler la « modernité thérapeutique » met en place, à partir d'essais in vitro (en laboratoire), des protocoles d'expérimentation randomisée en double aveugle sur des milliers de patients pendant plusieurs mois sinon plusieurs années pour tester l'efficacité de nouvelles molécules. La tradition clinique a connu d'incontestables succès par le passé, mais elle est particulièrement sujette à l'erreur logique Post hoc, ergo propter hoc qui consiste à inférer d'une succession temporelle (l'administration d'un médicament → la guérison du malade) une relation de cause à effet [39], et les médecins confrontés dans leur pratique quotidienne à des malades du Sida en grande souffrance sont de fait incapables de trouver des médications efficaces. Les associations comme Aides ou Act Up vont dès lors faire majoritairement confiance à la recherche médicale qui associe de multiples spécialistes (hématologues, immunologues, biologistes mais également statisticiens nécessaires pour la mise en place de protocoles fiables pour des essais contrôlés des différentes molécules) qui travaillent sous le contrôle d'une administration centralisée nécessaire notamment pour le contrôle des expérimentations à large échelle. Cette confiance n'empêche pas de multiples critiques à l'égard des pouvoirs publics accusés de ne pas prendre suffisamment en compte la gravité de l'épidémie et de mener notamment des actions de prévention insuffisantes à l'égard des publics particulièrement touchés (comme les homosexuels masculins, les consommateurs de drogue par injection ou les prisonniers) mais également à l'égard des firmes privées qui seront d'abord accusées d'un manque de transparence dans le choix des molécules testées dans les essais et dans la divulgation des résultats plus ou moins prometteurs des premiers essais. C'est dans cette perspective qu'Act Up-Paris notamment mettra sur pied un groupe d'activistes chargés de s'informer au mieux sur les recherches scientifiques : ce groupe va développer une véritable expertise en matière médicale qui permettra à l'ensemble de l'association de dialoguer d'égal à égal avec ces entreprises mais également avec les agences publiques comme l'ANRS (Agence publique française de recherches sur le sida) chargées de lutter contre l'épidémie. Act Up et les autres groupes d'activistes sont bien sûr motivés par l'urgence alors que l'épidémie tue des malades, et cette urgence (qui se manifeste aux yeux des médecins et savants à travers la figure du malade « enragé » qui veut survivre) contraste avec la distance raisonnable et raisonnée de la recherche médicale qui doit en principe travailler à l'écart de la pression médiatique et à l'abri des émotions. Dans ce contexte, les associations se révéleront cependant indispensables aux essais contrôlés dans la mesure où elles seules peuvent convaincre un nombre suffisant de malades de se soumettre à des protocoles lourds et peut-être inefficaces (ne serait-ce que parce que la moitié des malades ne reçoivent qu'un placebo). Mais l'expertise médicale des groupes de militants leur permettra précisément de surmonter cette opposition quand ils comprendront que les protocoles scientifiques les plus rigoureux laissent des marges d'appréciation et donc de négociation : « cette révélation, sur le tas, de la réalité concrète de la recherche médicale, est centrale dans la subversion du rapport pédagogique [entre scientifiques et associations de malades]. Elle tend à montrer, comme dans les autres expériences de participation du public à l'évaluation technologique, que les outils de la science sont susceptibles d'être améliorés lorsque des groupes concernés participent aux processus de concrétisation des innovations » [40]. Cela ne signifie pas que les relations entre les associations et les agences publiques ou les entreprises privées sont dès lors exemptes de tensions ou de conflits. Au contraire, les firmes pharmaceutiques seront accusées de ne pas délivrer, pour des raisons financières, suffisamment de molécules prometteuses avant leur autorisation officielle de mise sur le marché. Ce sera le cas en particulier avec les antiprotéases qui constitueront un des composants essentiels des futures bi et trithérapies. En même temps, les protocoles très stricts en double aveugle sur de longues périodes vont être assouplis grâce aux spécialistes en virologie qui montreront que la charge virale (c'est-à-dire la quantité de virus présents par unité de sang) est un bon indicateur de l'efficacité des thérapies. Dès lors, « tous les acteurs en viennent, in fine, à se rallier à la même philosophie d'essais : des tests de combinaisons de médicaments, basés sur le critère de la charge virale, et conduits pendant un temps très court [41]». Plusieurs enseignements peuvent sans doute être tirés de cette histoire dramatique. La première constatation est la confiance globale des associations dans la recherche scientifique comprise comme une entreprise collective où les découvertes sont bien plus souvent le fait d'une équipe que d'un individu, et où surtout le contrôle par les pairs assure la validité des découvertes [42]. Un second enseignement est qu'il est nécessaire d'acquérir une expertise scientifique (comme l'a fait Act Up-Paris) pour pouvoir discuter des résultats de la recherche : sans une telle expertise, les arguments scientifiques (qu'ils relèvent des agences publiques ou des firmes privées) ne peuvent être reçus que comme des dogmes sans espace de discussion. Le troisième enseignement, et sans doute le plus important, est que la vérité scientifique n'est pas monolithique et résulte de la collaboration (parfois conflictuelle) de plusieurs spécialités : les protocoles très stricts mis au point par les statisticiens ont pu ainsi être non pas supprimés mais assouplis grâce à l'intervention des virologues. L'accord d'un grand nombre de scientifiques issus de spécialités différentes permet d'établir une « vérité » qui se traduit aussi bien par des axes de recherche à explorer que par des protocoles expérimentaux, et mener ainsi idéalement à un progrès des connaissances. Cet accord « global » (qui peut parfois être révisé dans le cas des « révolutions scientifiques ») fonde la croyance raisonnable que les profanes peuvent avoir dans les autorités scientifiques, mais n'implique évidemment pas que les spécialistes détiennent la totale vérité dans tous ses aspects et toutes ses dimensions : dans certains cas comme celui de l'épidémie du Sida, il était important qu'un autre point de vue, celui des malades eux-mêmes, aussi éclairé que possible — ce qui justifie le rôle d'un groupe spécialisé — pèse sur certaines décisions. Un dernier point à relever est que la passion, l'émotion, la colère même, ne sont pas nécessairement contradictoires avec la recherche de la vérité : alors qu'on oppose souvent la raison et la passion (qui favoriserait l'erreur), l'action d'Act Up-Paris (et d'autres militants) a mis en lumière aussi bien aux yeux de l'opinion publique que des autorités l'urgence sanitaire que constituait cette épidémie nouvelle. Sans une telle action, il n'est pas sûr que la recherche aurait disposé des moyens nécessaires à une action efficace. |

L'expression « sciences molles », qui désigne essentiellement les sciences humaines, est évidemment dévalorisante : il ne s'agirait pas là de véritables sciences mais seulement de savoirs de différentes natures, faiblement vérifiés… Ceux qui ne sont pas spécialistes de ces domaines peuvent-ils dès lors leur faire confiance ? Un sociologue passant à la télévision a-t-il autant de crédit qu'un astrophysicien ? Et les conseils d'un ou d'une psychologue dans la presse ont-ils la même pertinence que ceux d'un climatologue annonçant un réchauffement global de la planète ?

On constate d'ailleurs que les spécialistes de ces différents savoirs sont loin d'afficher une unanimité de façade. Le problème de l'autisme donne ainsi lieu en France à des débats houleux entre les tenants d'une approche psychanalytique et les partisans de la psychologie cognitive et comportementale. Récemment, les attentats islamistes ont entraîné des interprétations opposées (et très conflictuelles) parmi les politologues, les uns parlant d'islamisation de la radicalité et les autres de radicalisation de l'Islam [43]. La sociologie est quant à elle traversée par des conflits sur le statut même de la discipline, les uns défendant une « science humaine » tandis que les autres parlent d'un « sport de combat » [44], et l'on retrouve les mêmes oppositions dans le domaine économique entre les défenseurs d'une « science expérimentale » dont les résultats seraient (au moins d'un point de vue probabiliste) parfaitement fiables [45], et d'autres « économistes atterrés » (selon le nom d'un de leurs groupes) qui remettent en cause les « fausses évidences » de la pensée dominante (de tendance néolibérale) dans le domaine.

Si l'on compare alors les raisons que les tenants des sciences « exactes » et ceux des sciences « humaines » avancent pour légitimer leurs savoirs, on observe quelques différences significatives.

Le recours à l'expérimentation est très peu systématique dans les sciences humaines et est même souvent absent : on trouve une telle démarche dans certains secteurs de la psychologie (dite expérimentale) et de l'économie mais elle est loin d'être généralisée même dans ces domaines ; dans d'autres, comme la sociologie ou l'anthropologie, elle est pratiquement absente [46]. En revanche, l'observation empirique avec de multiples instruments comme les statistiques est en principe générale et fonde la différence avec des discours comme « l'essayisme » ou la philosophie. Cette dimension empirique est particulièrement importante dans des domaines comme l'ethnographie et surtout l'histoire : un historien recueille d'abord un maximum d'informations documentaires, parfois très hétérogènes, même s'il essaie ensuite d'en rassembler le plus grand nombre dans une interprétation d'ensemble.

Démonstrations et raisonnements sont sans aucun doute présents dans les sciences humaines, mais il faut bien reconnaître que les procédures sont moins systématiques et moins explicites que dans les sciences « pures » (ou du moins certaines d'entre elles comme les mathématiques ou la physique). Certains domaines (comme l'économie ou la sociologie) recourent à des outils mathématiques ou statistiques sophistiqués (comme les analyses multivariées qui permettent par exemple de déterminer les facteurs déterminants des comportements observés chez un grand nombre d'individus [47]), mais cette scientificité visible n'empêche pas des questionnements sur leur utilisation (notamment sur la manière dont les données ont été recueillies) ou sur leur application à la réalité concrète (dans le cas de modèles mathématiques en économie [48]). En outre, beaucoup de chercheurs n'utilisent pas de tels instruments, et le degré de formalisation des recherches semble alors souvent plus faible que dans les sciences « exactes » : nombre d'ouvrages ou d'articles en sciences humaines ne comportent pas le moindre tableau, graphique, schéma, relevé statistique et reposent sur un développement argumentatif plus ou moins serré et convaincant.

Enfin, l'accord entre chercheurs en sciences humaines est certainement moins probant que dans les sciences exactes. Il y a des procédures de contrôle (ne serait-ce que par les diplômes et postes octroyés dans l'enseignement supérieur) et il existe des revues dites scientifiques avec des comités de lecture, mais le contrôle est certainement moins strict que dans les sciences exactes (même s'il y a là aussi, comme on l'a dit, de grandes zones d'incertitude), et les conflits entre écoles, maîtres à penser, approches différentes, méthodologies opposées laissent une grande place aux « hétérodoxes » qui, s'ils « réussissent », deviennent alors les tenants d'une nouvelle orthodoxie. S'il y a certainement des avancées en sciences humaines, il est moins évident de parler d'un progrès des connaissances dans une accumulation régulière ou continue.

Avons-nous donc des raisons de croire aux spécialistes en sciences humaines ? Si l'on fait la comparaison avec les sciences « pures », deux éléments qui pourraient fonder la conviction des profanes semblent manquer aux « sciences humaines ».

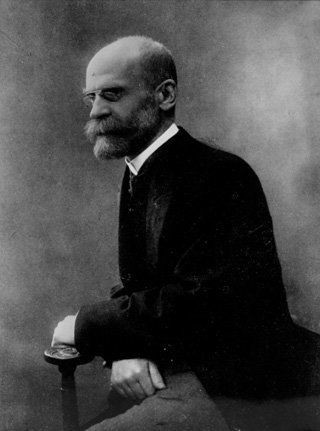

Émile Durkheim (1858-1917)

un des fondateurs de la sociologie moderne

La première est l'absence de découvertes « d'entités » inédites, étonnantes et improbables comme l'expansion de l'univers, le boson de Higgs, l'insuline ou la dérive des continents. Les notions proposées en sciences humaines sont généralement assez simples et demandent des explications relativement courtes pour être comprises même par des profanes. En sociologie par exemple, Émile Durkheim a avancé le concept apparemment nouveau d'anomie comme un des facteurs explicatifs du suicide : il désigne par là des situations où les individus sont confrontés à une absence de normes et de règles sociales, due à des transformations ou des bouleversements de la société environnante. Le concept est facile à comprendre même si la compréhension passe essentiellement par la multiplication des exemples de telles situations : dans une société paysanne traditionnelle, le contrôle du groupe impose à chaque individu des normes de comportement (comme celui du « bon père de famille ») alors que la société industrielle plonge de nombreux ouvriers venus des campagnes et abandonnés à eux-mêmes dans une situation d'anomie aiguë… Semblablement, le capital culturel chez Bourdieu est une transposition du capital économique au domaine des biens symboliques et peut se mesurer notamment à travers le niveau des diplômes scolaires (ceux de l'individu ou de ses parents) : il peut y avoir discussion notamment sur la manière d'objectiver cette notion mais elle est sans doute assez facile à comprendre. En psychanalyse, la distinction entre les instances du Moi, du Ça et du Surmoi est sans doute originale mais son explicitation est également relativement aisée : c'est l'application de cette distinction à des situations cliniques qui nécessite des exposés beaucoup plus complets et raffinés. En outre, l'objectivation de ces notions psychanalytiques reste largement sujette à débats et querelles [49]. De manière générale, les notions utilisées en sciences humaines, malgré les essais de définition et de redéfinition, restent assez floues et s'éloignent rarement du sens commun. La notion de classe sociale par exemple est étroitement reliée par Karl Marx à l'exploitation (essentiellement capitalistique, même s'il l'a étendue à l'ensemble de l'histoire humaine) mais a pris depuis lors de nombreuses autres acceptions, et son application à d'autres situations (notamment contemporaines) posera de nombreuses questions : la notion de prolétariat s'applique-t-elle encore aux sociétés occidentales contemporaines ? Peut-on dire que la « classe moyenne » est devenue la plus importante numériquement ? Ou pas ? Sur quelle base objective ?

Certains résultats en sciences humaines peuvent néanmoins être surprenants : ainsi, des expériences célèbres en psychologie sociale ont révélé que les individus, loin d'agir de façon libre, autonome et réfléchie, sont fortement enclins au conformisme, se soumettant facilement à l'avis du groupe environnant (expérience de Solomon Asch) ou à l'autorité (expérience de Stanley Milgram, déjà évoquée). Néanmoins, ces expériences, aussi originales soient-elles, s'expliquent par des motivations psychologiques facilement compréhensibles par chacun, même si l'on ne soupçonnait pas qu'elles pouvaient être aussi agissantes dans les comportements individuels.

Une deuxième grande différence avec les sciences pures (ou certaines d'entre elles) est évidemment l'absence presque générale d'expérimentation permettant de confirmer les différentes théories. L'exemple de l'économie est ici particulièrement illustratif. Les économistes développent quantité de modèles, généralement de nature mathématique, pour expliquer aussi bien les différents comportements des agents économiques (en microéconomie) que la situation des marchés ou leur évolution en fonction de multiples paramètres (en macroéconomie), mais ces modèles, aussi convaincants soient-ils au niveau théorique, ne sont pas réellement expérimentés et ne trouvent de confirmation que dans certaines situations considérées comme probantes ou suffisamment probantes par l'analyste. Il serait certainement faux de ne voir dans ces modèles que des constructions purement théoriques sans aucune vérification empirique, mais l'on comprend facilement qu'ils ne s'appliquent que partiellement sinon difficilement aux économies réelles où interviennent une multitude de facteurs parfois discordants [50]. Et l'on comprend aussi que les querelles entre économistes soient aussi importantes, surtout si l'on prend en compte la dimension politique souvent sous-jacente à ces querelles.

D'autres domaines (ou sous-domaines) en sciences humaines comme la psychologie promeuvent néanmoins une démarche expérimentale. Beaucoup d'études sont ainsi menées en comparant deux groupes, l'un soumis à une variation de l'environnement, l'autre non et considéré comme un groupe témoin : l'on peut ainsi analyser l'effet d'une tâche perturbatrice sur la capacité des sujets à mémoriser des listes de mots. Souvent techniques, portant sur des problématiques limitées, ces études représentent un champ du savoir en devenir (psychologie expérimentale mais aussi psychologie cognitive) qui, pour l'instant, n'a cependant pas produit de découverte « majeure » modifiant en profondeur la représentation commune du monde et du psychisme en particulier.